Chúng ta đã nghe không ít cảnh báo về nguy cơ của trí tuệ nhân tạo (AI) đối với con người nhưng có lẽ thông điệp mạnh mẽ hơn cả cho tới nay đã được nêu trong bức thư ngỏ ngày 30-5 trên trang web của tổ chức Trung tâm an toàn AI (Mỹ).

|

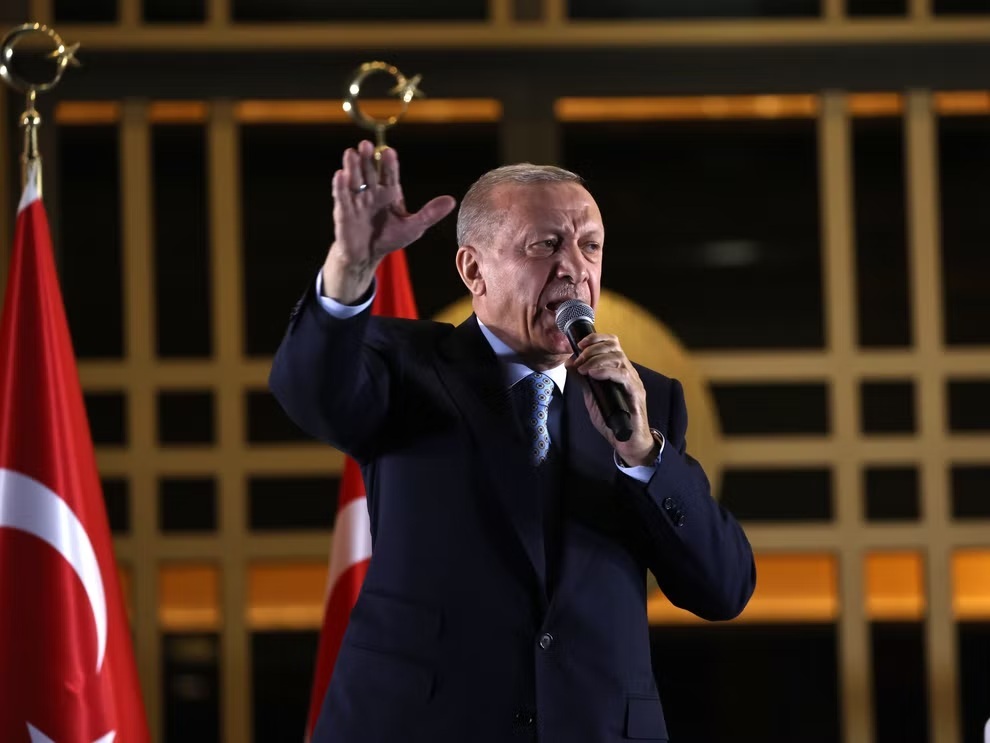

| Giao diện trang chủ của ứng dụng ChatGPT do Công ty OpenAI phát triển trên laptop của người dùng. Ảnh: Getty Images |

“Giảm thiểu nguy cơ tuyệt chủng từ AI nên là ưu tiên toàn cầu bên cạnh các nguy cơ có quy mô xã hội khác như đại dịch và chiến tranh hạt nhân”, đó là điểm nhấn đáng chú ý nhất trong thông điệp cảnh báo nhận được chữ ký đồng thuận của hơn 300 nhà nghiên cứu, kỹ sư, học giả và chuyên gia công nghệ AI toàn cầu. Tuần trước, Công ty OpenAI cũng so sánh AI với năng lượng hạt nhân, cho rằng công nghệ này cũng cần có cơ quan quản lý giống như Cơ quan năng lượng nguyên tử (IAEA).

Cấp độ cảnh báo mới

Những lo sợ với AI lâu nay chủ yếu bắt nguồn từ nguy cơ đối với việc làm và tình trạng đứt gãy về kinh tế, chính trị chứ không phải mối đe dọa trực tiếp tới sinh mạng con người nhưng cảnh báo ngày 30-5 đánh dấu cấp độ đáng lo ngại khác. Trong thư ngỏ, giới chuyên gia AI cho rằng, các mô hình AI có thể sẽ sớm thông minh hơn, mạnh mẽ hơn con người, và đã đến lúc nhân loại phải áp dụng những hạn chế cần thiết để chúng không giành thế kiểm soát con người hoặc thậm chí là phá hủy thế giới.

Trong số hơn 300 chuyên gia AI ký đồng thuận với Trung tâm an toàn AI, có CEO của 3 công ty đang được nhìn nhận như những phòng thí nghiệm AI tiên phong hiện nay, gồm: ông Sam Altman, CEO công ty OpenAI, đơn vị sở hữu ChatGPT và được tập đoàn Microsoft rót vốn lớn; ông Demis Hassabis, CEO công ty DeepMind của Google; ông Dario Amodei, CEO công ty Anthropic. Ngoài ra còn có chữ ký của ông Geoffrey Hinton, người được mệnh danh là “bố già AI” và việc ông từ chức khỏi Google gần đây cũng tốn không ít giấy mực của truyền thông quốc tế. Những thông điệp kêu gọi về việc phải “dựng rào” quản lý AI ngày một khẩn thiết hơn trong những tháng qua khi nhiều doanh nghiệp đang chạy đua phát triển những nền tảng ứng dụng công nghệ này.

Người ta hẳn chưa quên bức thư ngỏ khác hồi tháng 3-2023 (tới nay đã thu nhập được hơn 31.800 chữ ký đồng thuận), cũng kêu gọi hãy tạm dừng đào tạo AI trong 6 tháng để không làm phiên bản tiếp theo của GPT-4, phiên bản mới nhất của chatbot ChatGPT. Dù vậy, bức thư ngỏ ngày 30-5 tạo sự khác biệt đáng kể bởi lần này đã có chữ ký đồng thuận của lãnh đạo các công ty AI và những tập đoàn công nghệ đang đầu tư cho họ như Google, Microsoft…

Nguy cơ đang ở rất gần

NPR dẫn lời ông Hinton nhận định, các chương trình AI đang trong lộ trình vượt qua trình độ của những người tạo ra nó sớm hơn dự đoán rất nhiều. “Trong một thời gian dài, tôi từng nghĩ chúng ta vẫn còn cách điều đó khoảng 30 tới 50 năm nữa… Nhưng nay, tôi cho rằng chúng ta đã ở rất gần điều đó, có lẽ chỉ còn cách khoảng 5 năm”, ông Hinton nói.

Trong khi đó, trên Twitter, ông Dan Hendrycks, Giám đốc Trung tâm an toàn AI, lưu ý, trong tương lai ngay trước mắt, AI đặt ra những rủi ro cấp bách về “sự thiên vị có hệ thống, thông tin sai, sử dụng với mục đích xấu, tấn công mạng và bị sử dụng làm vũ khí”. Nhà khoa học máy tính này cho rằng, nhân loại cần nỗ lực giải quyết cùng lúc tất cả những nguy cơ này. “Từ góc độ quản lý nguy cơ, việc chỉ ưu tiên giải quyết các nguy cơ hiện tại cũng bất cẩn như việc phớt lờ chúng vậy”, ông Dan Hendrycks nhấn mạnh.

|

G7 bàn cách quản lý AI Theo NHK, ngày 30-5, nhóm các nước công nghiệp phát triển hàng đầu thế giới (G7) tổ chức hội nghị đầu tiên bàn về tiêu chuẩn kỹ thuật toàn cầu nhằm quản lý và kiểm soát AI. Sự kiện này được tổ chức trực tuyến và là sự tiếp tục của khung chương trình làm việc được vạch ra tại hội nghị thượng đỉnh G7 vừa qua tại Nhật Bản. Các bên tham gia nhất trí về việc cần hành động nhanh hơn để xác định cả lợi ích lẫn nguy cơ của AI tạo sinh như ChatGPT, đồng thời tiếp tục thảo luận về việc làm sao để bảo vệ bản quyền và giải quyết nạn tin giả. Cuối năm 2023, bộ trưởng các nước G7 sẽ gặp nhau lần nữa để thống nhất lại các quan điểm cơ bản nhằm thiết lập các nguyên tắc chung để thúc đẩy AI đáng tin cậy. Có một số khác biệt giữa các nước về vấn đề AI tạo sinh. Trong khi các nước EU muốn thiết lập nguyên tắc và quy định quản lý nghiêm ngặt, một số nước khác, trong đó có Nhật Bản, muốn khuyến khích phát triển và sử dụng công nghệ này. Đạo luật AI của Liên minh châu Âu vốn đang được các nhà lập pháp khối này xem xét chắc chắn sẽ thiết lập tiêu chuẩn công nghệ tương tự, song thời gian áp dụng sớm nhất có thể phải tới năm 2025. |

TRẦN ĐẮC LUÂN